MemOS ha lanzado recientemente una herramienta muy interesante para quienes trabajan con agentes: su OpenClaw Plugin, una capa de memoria “drop-in” diseñada para equipos que desarrollan sobre OpenClaw. Según sus propios benchmarks, promete un recorte de tokens del 60% al 70% en comparación con la memoria nativa; así es, has leído bien: menos contexto pesado, menos costos y menos ruido operativo.

En específico, el plugin está diseñado para mantener contexto a largo plazo sin que el sistema tenga que “tragarse” constantemente enormes ventanas de conversación. Sin embargo, lo relevante no es solo el ahorro, sino la capacidad de preservar una personalización coherente de los agentes cuando un proyecto se extiende durante semanas o incluso meses.

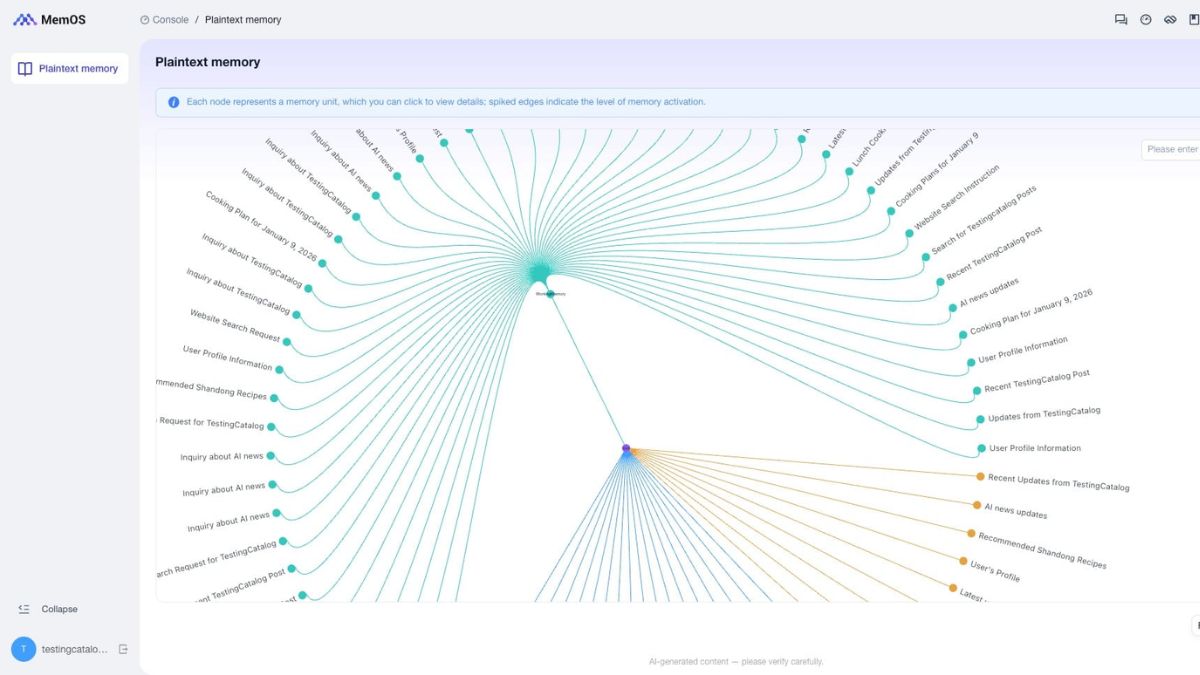

MemOS defiende una idea que se vuelve cada vez más lógica: la memoria no debería ser un truco añadido al prompt, sino una capa del sistema. En lugar de recargar continuamente amplias ventanas de contexto, su enfoque desplaza el almacenamiento y la recuperación de información a una capa de memoria dedicada, separada del flujo inmediato del modelo.

MemOS Plugin for @openclaw just dropped.

The problem: OpenClaw burns tokens on repeated context and forgets stuff between sessions.

The fix: MemOS handles memory retrieval intelligently.

– Lower token usage

– Persistent cross-session recall

– Runs locally on your machineQuick… pic.twitter.com/ySPqgJ9BMZ

— MemOS (@MemOS_dev) February 6, 2026

En otras palabras, en lugar de pagar repetidamente por recordarle al modelo quién eres, qué estabas haciendo o qué decisiones tomaste, puedes almacenar esa información externamente y recuperarla solo cuando sea necesario. Este enfoque no elimina la necesidad de contexto, pero busca hacerlo selectivo y estratégico, en lugar de usar una carga gigante para cubrir todas las áreas por falta de herramientas más efectivas.

Además, hay un aspecto práctico crucial: el plugin se presenta como un componente “enchufable” dentro de OpenClaw, diseñado para integrarse donde ya esté funcionando tu stack. Esta promesa de integración directa es fundamental para equipos que no quieren reconstruir su arquitectura desde cero.

El denominado impuesto de contexto no tiene el mismo impacto en una demostración que en producción. Cuando un agente opera a diario, realiza tareas de múltiples pasos o está en un producto de pago donde cada token tiene un costo real, el ahorro deja de ser una anécdota y se convierte en una cuestión estructural.

Es decir, cuando pasas de “mira lo increíble que es mi agente” a “esto lo utiliza todo un equipo a diario”, cada ineficiencia se amplifica. El efecto acumulado de recargar contexto innecesario puede aumentar los costos y deteriorar la experiencia sin que te des cuenta hasta que llegue el momento crítico.

Sin embargo, la problemática de la memoria no es solo financiera. También se trata de consistencia y fiabilidad: que el agente no se contradiga, que no olvide las preferencias del usuario y que no se pierda en la mitad de un flujo largo. En proyectos extensos, lo habitual es terminar parcheando con resúmenes manuales, prompts cada vez más largos, recordatorios constantes y textos repetidos que nadie desea mantener. Esta espiral no escalará bien, especialmente cuando el producto ya está en manos de usuarios reales.

Estamos en medio de una fiebre de colaboración multiagente, con nombres como AutoGen, CrewAI u OpenClaw siendo parte de muchas discusiones técnicas. El concepto es poderoso: varios agentes especializados realizando tareas en un mini-equipo coordinado.

Sin embargo, en la práctica surge un fallo recurrente: cada agente tiene un “cerebro” aislado, sin visibilidad real de las acciones de los demás. Esta fragmentación suele resultar en trabajo duplicado, contexto incoherente y transferencias de información a base de copiar y pegar entre agentes o sesiones diferentas.

Paradójicamente, eso es exactamente lo opuesto a lo que prometía el enfoque multiagente: coordinación fluida, eficiencia y especialización real. Cuando la memoria no está alineada, lo que debería ser un equipo termina funcionando como un conjunto de freelancers que no comparten documentación.

Aquí es donde MemOS busca abordar el problema de raíz. Su plugin permite que múltiples agentes trabajen sobre una memoria compartida, de manera que, en lugar de mantener repositorios aislados por cada agente, todo el equipo puede leer y escribir desde un espacio unificado.

En la práctica, esto significa que lo que produce el Agente A puede ser utilizado directamente por el Agente B sin que tú tengas que actuar como mensajero humano. El resultado esperado es una colaboración más cercana a la lógica de un equipo real: con trazas accesibles, información persistente y una especie de “documentación viva” que evoluciona con el proyecto.

Por supuesto, el compartir memoria también plantea un desafío. Si todo se agrupa sin pautas claras, el riesgo es crear contaminación de contexto o decisiones cruzadas que generen más confusión que valor. Por lo tanto, la clave no está solo en unificar, sino en hacerlo con criterios de acceso, organización y recuperación bien definidos.

MemOS presenta esta arquitectura como la solución para evitar que la colaboración multiagente se convierta en duplicación de trabajo o desajustes constantes. Bien implementado, un pool común no es un caos compartido, sino un sistema donde la información relevante está disponible cuando se necesita y no cuando estorba.

El público objetivo es bastante evidente: creadores de agentes B2B, equipos que desarrollan herramientas para programadores, copilotos internos y cualquier proyecto donde la memoria represente un punto crítico en términos de costo y consistencia. En esos entornos, cada token tiene un valor y cada incoherencia pesa.

El plugin se distribuye a través de GitHub y se presenta como un componente que se ajusta a cualquier entorno donde OpenClaw ya esté operativo, lo que refuerza su modularidad. Sin embargo, no llega en un vacío. La memoria se está convirtiendo en el nuevo campo de batalla dentro de los “agent stacks”, con productos como mem0, supermemory o memU compitiendo por el mismo espacio mental —y presupuestario— dentro de las empresas.

Se posiciona como un “memory OS” para aplicaciones y agentes, con identidad propia, un panel de control y una huella open source más amplia bajo la organización MemTensor. En otras palabras, no solo se promociona como un parche táctico para hoy, sino como una capa reutilizable y persistente que puede compartirse entre agentes, sesiones y productos.

Si los números del 60–70% de ahorro se mantienen en situaciones reales, esto deja de ser un “nice to have” y pasa a ser infraestructura. Al final, la IA aplicada rara vez se ve obstaculizada por la falta de modelos potentes; más bien, se detiene cuando los costes aumentan o cuando los agentes dejan de ser fiables más allá de la primera semana de uso intenso.

Como siempre, queda la prueba de fuego: qué tan fácil es la integración en entornos reales, cómo se desarrolla en equipos grandes y si la memoria compartida consigue mantener el orden sin convertirse en un cajón desastre. Si MemOS tiene éxito, estaremos ante el siguiente paso lógico en la evolución de los agentes: dejar de pagar repetidamente el mismo impuesto de contexto y comenzar a tratar la memoria como lo que realmente es, una pieza central del producto. La competencia, sin duda, ya está tomando nota.

No hay blogs

¿Tu negocio ya aparece en Catalogea? ¡Excelente! Eso significa que estamos ayudándote a tener más visibilidad.

Pero si aún no lo has reclamado, es momento de tomar el control de tu perfil.

Para verificar que eres el dueño o representante autorizado, necesitamos que cumplas al menos una de estas condiciones:

Nombre del negocio: [Campo de texto]

Tu nombre completo: [Campo de texto]

Tu relación con el negocio: [Dropdown: Dueño, Encargado, Empleado, Agencia, Otro]

Correo electrónico de contacto: [Campo de texto]

Teléfono del negocio: [Campo de texto]

Prueba de propiedad: [Botón para subir archivo o enlace a sitio/red social]

Mensaje adicional (opcional): [Campo de texto]

[ ] Confirmo que soy el representante autorizado y acepto los Términos de uso y la Política de privacidad.

Al enviar tu solicitud, revisaremos la información en menos de 72 horas y nos comunicaremos contigo para confirmar tu acceso.

Puedes enviarnos una solicitud de modificación o eliminación haciendo clic aquí, indicando tu relación con el negocio y el motivo.

Catalogea publica perfiles de negocios usando información pública extraída de fuentes accesibles en internet (Google Maps, redes sociales, sitios web oficiales, entre otros). Nuestro objetivo es brindar mayor exposición a negocios locales. No reclamamos propiedad sobre estos negocios ni garantizamos la exactitud de los datos si el perfil no ha sido verificado.